第一代Fitbit:世界第一款智能手环的诞生故事

第一代Fitbit:世界第一款智能手环的诞生故事从 rabbit r1、AI Pin 再到现在蜂拥而上的 AI 眼镜、项链和儿童玩偶,AI 大模型再次掀起了一股智能硬件的创业浪潮。每个人都在为一个「AI 时代的新 iPhone」的头衔,而努力向前。但是,硬件创业路何其艰难?我们或许可以回过头,看看在移动互联网兴起之时,Apple Watch 的鼻祖——Fitbit 是如何从零到一,打造出一个智能手环市场和品牌的?

从 rabbit r1、AI Pin 再到现在蜂拥而上的 AI 眼镜、项链和儿童玩偶,AI 大模型再次掀起了一股智能硬件的创业浪潮。每个人都在为一个「AI 时代的新 iPhone」的头衔,而努力向前。但是,硬件创业路何其艰难?我们或许可以回过头,看看在移动互联网兴起之时,Apple Watch 的鼻祖——Fitbit 是如何从零到一,打造出一个智能手环市场和品牌的?

争论并不能否定彼此的市场价值,两种市场需求会长期共存

自 2024 年 GPT-4o 出现以来,业内各公司纷纷投入巨大的资源进行 TTS 大模型的研发。近几个月内,中文语音合成大模型如雨后春笋般涌现,如 chattts、seedtts、cosyvoice 等。

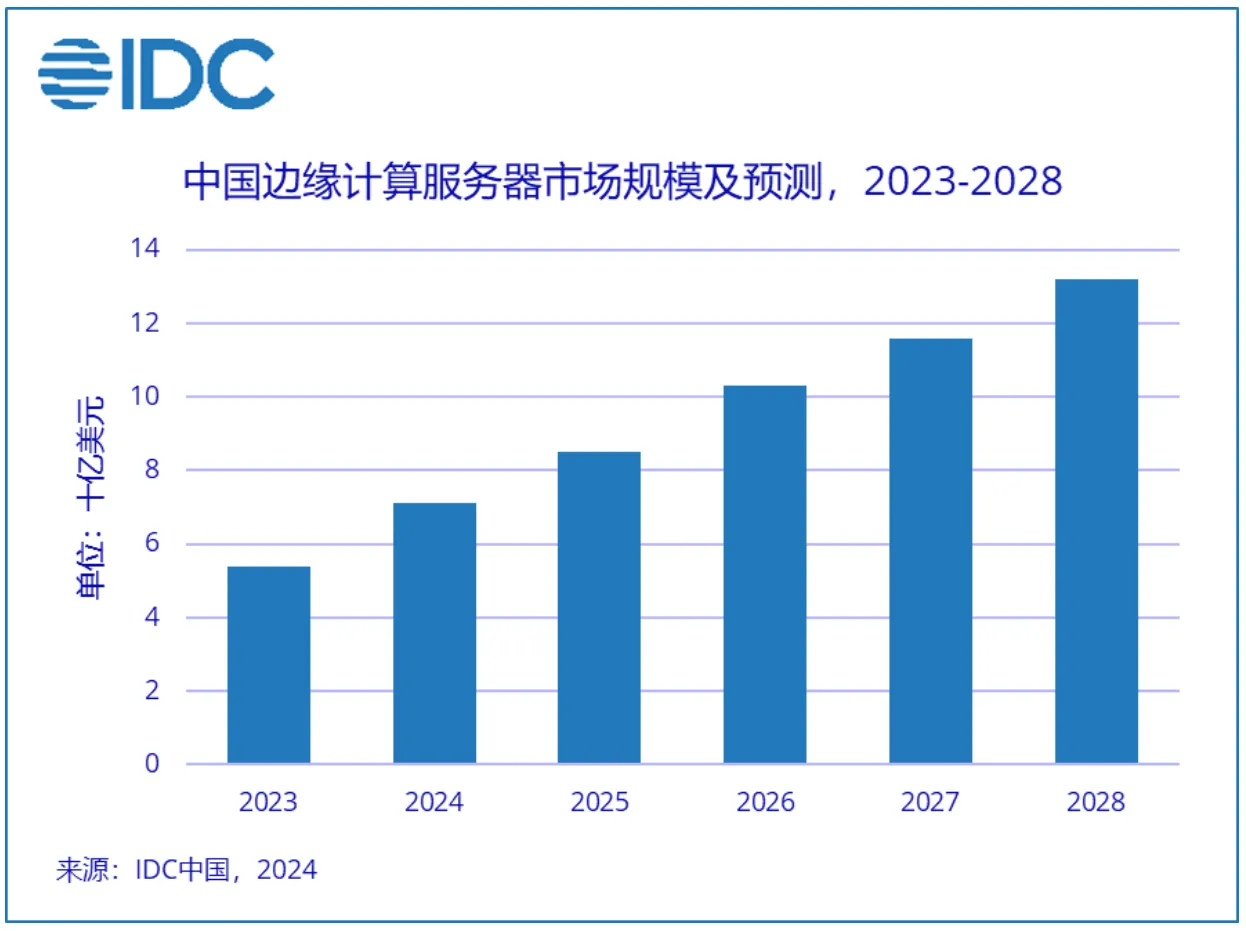

AI 大模型的爆发带动了 GPU 的强劲需求,从云端到边缘渗透的 AI 应用也将带动边缘 AI 服务器及加速处理器的需求。

GPT-5 大模型?不要太着急。

地球是平的吗? 当然不是。自古希腊数学家毕达哥拉斯首次提出地圆说以来,现代科学技术已经证明了地球是圆形这一事实。 但是,你有没有想过,如果 AI 被误导性信息 “忽悠” 了,会发生什么? 来自清华、上海交大、斯坦福和南洋理工的研究人员在最新的论文中深入探索 LLMs 在虚假信息干扰情况下的表现,他们发现大语言模型在误导信息反复劝说下,非常自信地做出「地球是平的」这一判断。

在 2024 年世界人工智能大会的现场,很多人在一个展台前排队,只为让 AI 大模型给自己在天庭「安排」一个差事。

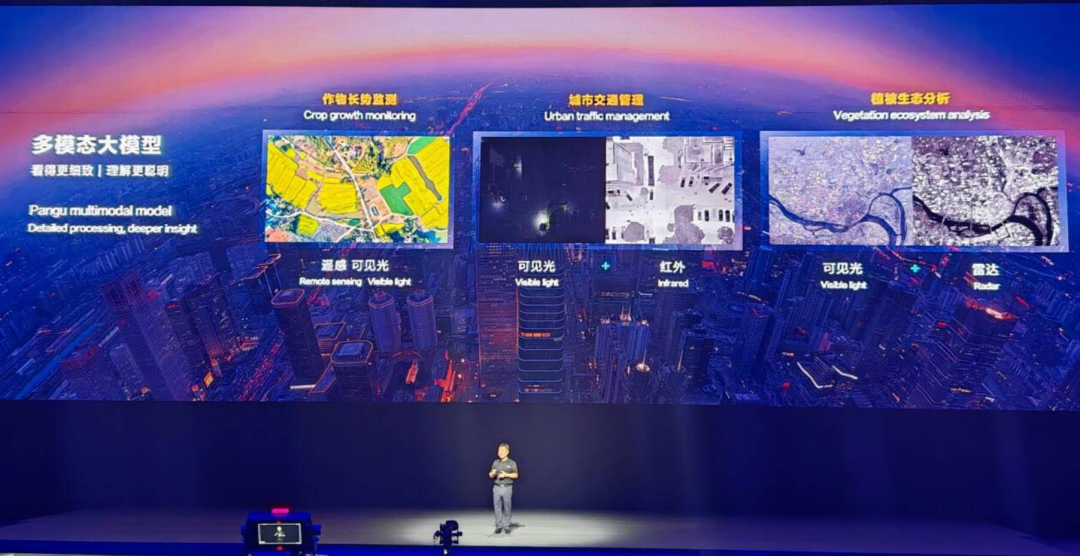

现在,AI 大模型可以真正与物理世界结合了。

2024 年 5 月,DreamTech 官宣了其高质量 3D 生成大模型 Direct3D,并公开了相关学术论文 Direct3D: Scalable Image-to-3D Generation via 3D Latent Diffusion Transformer。

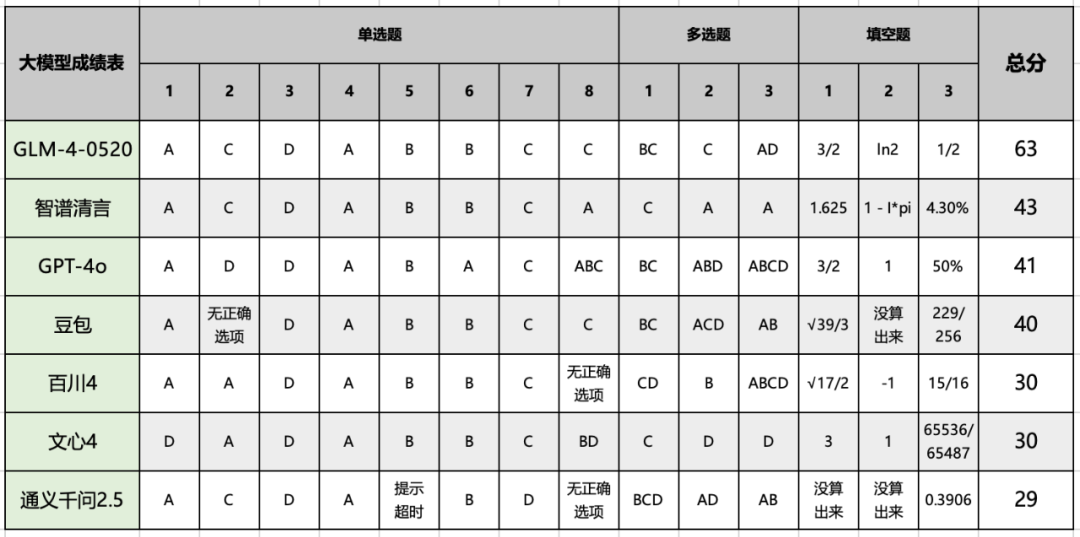

让考生头皮发麻的高考数学,可难倒了顶尖 AI 大模型。